ZH, 08/12/2023

Por Tyler Durden

Enquanto os especialistas alertam sobre o risco de extinção humana, o Departamento de Defesa avança a todo vapor...

O recente drama da diretoria sobre a liderança da OpenAI – a startup de tecnologia com sede em São Francisco por trás do imensamente popular programa de computador ChatGPT – foi descrito como uma luta pelo poder corporativo, um conflito de personalidade movido pelo ego e uma disputa estratégica sobre o lançamento de mais variantes ChatGPT compatíveis. Foi tudo isso e muito mais, mas no fundo representou uma luta invulgarmente amarga entre os funcionários da empresa que favorecem a pesquisa irrestrita sobre formas avançadas de inteligência artificial (IA), e aqueles que, temendo os resultados potencialmente catastróficos de tais esforços, procuraram abrandar o ritmo do desenvolvimento da IA.

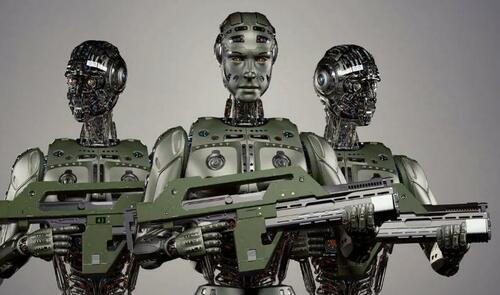

Aproximadamente ao mesmo tempo em que esta batalha memorável estava em andamento, uma luta semelhante estava se desenrolando nas Nações Unidas em Nova York e nos escritórios do governo em Washington, DC, sobre o desenvolvimento de sistemas de armas autônomos – navios drones, aviões e tanques operados pela IA em vez de humanos. Nesta disputa, uma ampla coligação de diplomatas e ativistas dos direitos humanos procurou impor uma proibição juridicamente vinculativa de tais dispositivos – chamados de “robôs assassinos” pelos opositores – enquanto funcionários dos Departamentos de Estado e de Defesa defenderam o seu rápido desenvolvimento.

Em causa em ambos os conjuntos de disputas estão opiniões concorrentes sobre a fiabilidade das formas avançadas de IA, especialmente os “grandes modelos de linguagem” utilizados em sistemas de “IA generativa” como o ChatGPT. (Programas como esses são chamados de “geradores” porque podem criar textos ou imagens de qualidade humana com base em uma análise estatística de dados coletados na Internet). Aqueles que defendem o desenvolvimento e a aplicação de IA avançada – seja no setor privado ou no sector militar – afirmam que tais sistemas podem ser desenvolvidos com segurança; aqueles que alertam contra tal ação, dizem que não pode, pelo menos não sem salvaguardas substanciais.

Sem entrar nos detalhes do drama da OpenAI – que terminou, por enquanto, em 21 de novembro com a nomeação de novos membros para o conselho e o retorno do gênio da IA Sam Altman como executivo-chefe, após ter sido demitido cinco dias antes – é evidente que a crise foi desencadeada por preocupações entre os membros do conselho de administração original, de que Altman e a sua equipe estavam se desviando demais na direção do rápido desenvolvimento da IA, apesar das promessas de exercer maior cautela.

Tal como Altman e muitos dos seus colegas veem as coisas, os técnicos humanos estão prestes a criar “IA geral” ou “superinteligência” – programas de IA tão poderosos que podem duplicar todos os aspectos da cognição humana e programar-se a si próprios, tornando a programação humana desnecessária. Alega-se que tais sistemas serão capazes de curar a maioria das doenças humanas e realizar outros milagres benéficos – mas também, alertam os detratores, eliminarão a maioria dos empregos humanos e poderão, eventualmente, optar por eliminar completamente os humanos.

“Em termos de potenciais vantagens e desvantagens, a superinteligência será mais poderosa do que outras tecnologias com as quais a humanidade teve de enfrentar no passado”, escreveram Altman e os seus principais tenentes em Maio. “Podemos ter um futuro dramaticamente mais próspero; mas temos que gerenciar o risco para chegar lá.”

Para Altman, como para muitos outros no campo da IA, esse risco tem uma dimensão “existencial”, implicando o possível colapso da civilização humana – e, no extremo, a extinção humana. “Acho que se esta tecnologia der errado, pode dar muito errado”, disse ele em uma audiência no Senado em 16 de maio. Altman também assinou uma carta aberta divulgada pelo Center for AI Safety em 30 de maio alertando sobre o possível “risco de extinção de IA.” Mitigar esse risco, afirma a carta, “deveria ser uma prioridade global, juntamente com outros riscos à escala social, como pandemias e guerra nuclear”.

No entanto, Altman e outros altos responsáveis da IA acreditam que a superinteligência pode e deve ser prosseguida, desde que sejam instaladas salvaguardas adequadas ao longo do caminho. “Acreditamos que os benefícios das ferramentas que implementámos até agora superam largamente os riscos, mas garantir a sua segurança é vital para o nosso trabalho”, disse ele ao subcomitê do Senado sobre privacidade, tecnologia e lei.

Washington promove o uso “responsável” da IA na guerra

Um cálculo semelhante relativo à exploração de IA avançada rege a perspectiva de altos funcionários dos Departamentos de Estado e de Defesa, que argumentam que a inteligência artificial pode e deve ser usada para operar futuros sistemas de armas – desde que seja feito de forma “responsável”.

“Não podemos prever como as tecnologias de IA evoluirão ou o que serão capazes de fazer em um ano ou cinco anos”, disse o Amb. Bonnie Jenkins, subsecretária de Estado para o controle de armas e não-proliferação, numa apresentação na ONU em 13 de Novembro . No entanto, observou ela, os Estados Unidos estavam determinados a “implementar as políticas necessárias e a construir as capacidades técnicas para permitir o desenvolvimento e a utilização responsáveis [da IA pelos militares], independentemente dos avanços tecnológicos”.

Jenkins esteve na ONU naquele dia para revelar uma “Declaração Política sobre o Uso Militar Responsável de Inteligência Artificial e Automação”, um apelo inspirado nos EUA para restrições voluntárias no desenvolvimento e implantação de armas autônomas habilitadas para IA. A declaração reconhece, entre outras coisas, que “os Estados devem garantir que a segurança, a proteção e a eficácia das capacidades militares de IA sejam sujeitas a testes apropriados e rigorosos” e que “os Estados devem implementar salvaguardas apropriadas para mitigar os riscos de falhas nas capacidades da IA militar, como a capacidade de… desativar sistemas implantados, quando tais sistemas demonstram comportamento não intencional.”

Nada disto, contudo, constitui uma obrigação juridicamente vinculativa dos Estados que assinam a declaração; em vez disso, implica simplesmente uma promessa de respeitar um conjunto de melhores práticas, sem qualquer exigência de demonstração do cumprimento dessas medidas ou risco de punição se for constatado o seu incumprimento.

Embora várias dezenas de países – a maioria aliados próximos dos Estados Unidos – tenham assinado a declaração, muitas outras nações, incluindo Áustria, Brasil, Chile, México, Nova Zelândia e Espanha, insistem que o cumprimento voluntário de um conjunto de padrões, concebidos pelos EUA, é insuficiente para proteger contra os perigos representados pela implantação de armas habilitadas para IA. Em vez disso, procuram um instrumento juridicamente vinculativo que estabeleça limites estritos à utilização de tais sistemas ou os proíba totalmente. Para estes intervenientes, os riscos de tais armas “se tornarem desonestas” e de realizarem ataques não autorizados a civis são simplesmente demasiado grandes para permitir a sua utilização em combate.

“A humanidade está prestes a cruzar um limiar de profunda importância quando a decisão sobre a vida ou a morte já não é tomada pelos humanos, mas sim com base em algoritmos pré-programados. Isto levanta questões éticas fundamentais”, disse o Embaixador. Alexander Kmentt, negociador-chefe da Áustria para o desarmamento, controle de armas e não-proliferação, ao The Nation.

Durante anos, a Áustria e uma série de países latino-americanos tentaram impor a proibição de tais armas sob a égide da Convenção sobre Certas Armas Convencionais (CCW), um tratado da ONU de 1980, que visa restringir ou proibir armas consideradas causadoras de sofrimento desnecessário aos combatentes ou afetar civis indiscriminadamente. Estes países, juntamente com o Comité Internacional da Cruz Vermelha e outras organizações não governamentais, afirmam que as armas totalmente autônomas se enquadram nesta categoria, uma vez que se revelarão incapazes de distinguir entre combatentes e civis no calor da batalha, conforme exigido pelo direito internacional. Embora a maioria dos partidos da CCW pareçam compartilhar esta opinião e sejam a favor de controles rigorosos sobre armas autônomas, as decisões dos estados signatários são tomadas por consenso e um punhado de países, incluindo Israel, a Rússia e os Estados Unidos, usaram o seu poder de veto impedindo a adoção de qualquer medida desse tipo. Isto, por sua vez, levou os defensores da regulamentação a recorrerem à Assembleia Geral da ONU – onde as decisões são tomadas por maioria de votos e não por consenso – como uma arena para progressos futuros nesta questão.

Em 12 de Outubro, pela primeira vez, a Primeira Comissão da Assembleia Geral – responsável pela paz, segurança internacional e desarmamento – abordou os perigos representados pelas armas autônomas, votando por uma ampla maioria – 164 a 5 (com 8 abstenções) – para instruir o secretário-geral a realizar um estudo abrangente do assunto. O estudo, a ser concluído a tempo para a próxima sessão da Assembleia Geral (no outono de 2024), visa examinar os “desafios e preocupações” que essas armas levantam “do ponto de vista humanitário, jurídico, de segurança, tecnológico e ético e sobre o papel dos humanos no uso da força”.

Embora a medida da ONU não imponha quaisquer limitações vinculativas ao desenvolvimento ou utilização de sistemas de armas autônomos, ela estabelece as bases para a futura adoção de tais medidas, identificando uma série de preocupações sobre a sua implantação e insistindo que o secretário-geral, ao realizar o relatório exigido, investigue detalhadamente esses perigos, inclusive buscando as opiniões e conhecimentos de cientistas e organizações da sociedade civil.

“O objetivo é obviamente avançar na regulamentação dos sistemas de armas autônomos”, indicou o Embaixador Kmentt. “A resolução deixa claro que a esmagadora maioria dos estados quer abordar esta questão com urgência.”

O que ocorrerá na reunião da Assembleia Geral do próximo ano não pode ser previsto, mas se Kmentt estiver certo, podemos esperar um debate internacional muito mais animado sobre a conveniência de permitir a implantação de sistemas de armas habilitados para IA – quer os participantes tenham ou não concordado com o medidas voluntárias defendidas pelos Estados Unidos.

No Pentágono, a toda velocidade

Para os funcionários do Departamento de Defesa, no entanto, a questão está em grande parte resolvida: os Estados Unidos prosseguirão com o rápido desenvolvimento e implantação de numerosos tipos de sistemas de armas autônomos habilitados para IA. Isto ficou evidente em 28 de agosto, com o anúncio da iniciativa “Replicator” pela Secretária Adjunta de Defesa Kathleen Hicks.

Observando que os Estados Unidos devem preparar-se para uma possível guerra com as forças armadas da China, o Exército de Libertação Popular (ELP), num futuro não muito distante, e que as forças dos EUA não podem igualar os inventários de armas do ELP numa base item a item (tanque por tanque, navio por navio, etc.), Hicks argumentou que os EUA devem estar preparados para superar a superioridade da China em medidas convencionais de poder – a sua “massa” militar – através da implantação de “multidões de milhares” de armas autônomas.

“Para permanecermos à frente, vamos criar um novo estado da arte – assim como a América fez antes – aproveitando sistemas autônomos atribuíveis [ou seja, descartáveis] em todos os domínios”, disse ela a executivos corporativos em uma reunião da Associação Industrial de Defesa Nacional em Washington. “Vamos combater a massa do ELP com a nossa própria massa, mas a nossa será mais difícil de planejar, mais difícil de atingir, mais difícil de vencer.”

Num discurso de acompanhamento, proferido em 6 de setembro, Hicks forneceu (um pouco) mais detalhes sobre o que ela chamou de sistemas de armas autônomos atribuíveis em todos os domínios (ADA2). “Imagine conjuntos distribuídos de sistemas ADA2 autopropelidos flutuando… repletos de sensores…. Imagine frotas de sistemas ADA2 baseados em terra fornecendo suporte logístico inovador, explorando o futuro para manter as tropas seguras…. Imagine bandos de sistemas ADA2 [aéreos], voando em todos os tipos de altitudes, realizando uma série de missões, com base no que vimos na Ucrânia.”

De acordo com a orientação oficial, Hicks garantiu ao seu público que todos esses sistemas “serão desenvolvidos e colocados em campo de acordo com a nossa abordagem responsável e ética à IA e aos sistemas autônomos”. Mas, exceto aquele aceno de uma só linha à segurança, toda a ênfase nas suas conversações foi na eliminação de estrangulamentos burocráticos, a fim de acelerar o desenvolvimento e a implantação de armas autônomas. “Se [estes gargalos] não forem resolvidos”, declarou ela em 28 de agosto, “nossas engrenagens ainda funcionarão muito lentamente e nossos motores de inovação ainda não funcionarão na velocidade e na escala que precisamos. E isso não podemos suportar.”

E assim, os poderes constituídos – tanto no Vale do Silício como em Washington – tomaram a decisão de prosseguir com o desenvolvimento e utilização de versões ainda mais avançadas de inteligência artificial, apesar dos avisos de cientistas e diplomatas de que a segurança destes programas não pode ser garantida, e que a sua utilização indevida pode ter consequências catastróficas. A menos que sejam feitos maiores esforços para retardar estes esforços, poderemos muito bem descobrir o que essas consequências podem implicar.

Artigos recomendados: DARPA e Guerra

Fonte:https://www.zerohedge.com/military/pentagons-rush-deploy-ai-enabled-weapons-going-kill-us-all

Nenhum comentário:

Postar um comentário