BBC, 05/10/2023

Por Jack Goodman

Uma campanha que utiliza inteligência artificial para se passar por Omar al-Bashir, o antigo líder do Sudão, recebeu centenas de milhares de visualizações no TikTok, aumentando a confusão online num país dilacerado pela guerra civil.

Uma conta anônima tem postado o que diz serem “gravações vazadas” do ex-presidente desde o final de agosto. O canal postou dezenas de clipes – mas a voz é falsa.

Bashir, que foi acusado de organizar crimes de guerra e deposto pelos militares em 2019, não é visto em público há um ano e acredita-se que esteja gravemente doente. Ele nega as acusações de crimes de guerra.

O mistério em torno do seu paradeiro acrescenta uma camada de incerteza a um país em crise após o início dos combates em Abril entre os militares, atualmente no comando, e o grupo rival de milícias Forças de Apoio Rápido.

Campanhas como esta são significativas porque mostram como novas ferramentas podem distribuir conteúdo falso de forma rápida e barata através das redes sociais, dizem os especialistas.

“É a democratização do acesso a tecnologias sofisticadas de manipulação de áudio e vídeo que mais me preocupam”, diz Hany Farid, que pesquisa ciência forense digital na Universidade da Califórnia, em Berkeley, nos EUA.

“Atores sofisticados conseguiram distorcer a realidade durante décadas, mas agora a pessoa comum com pouco ou nenhum conhecimento técnico pode criar conteúdo falso de forma rápida e fácil.”

As gravações são postadas em um canal chamado The Voice of Sudan. As postagens parecem ser uma mistura de clipes antigos de coletivas de imprensa durante tentativas de golpe, reportagens e diversas “gravações vazadas” atribuídas a Bashir. As postagens muitas vezes fingem ter sido retiradas de uma reunião ou conversa telefônica e parecem granuladas, como seria de esperar de uma linha telefônica ruim.

|

| Várias postagens incluíam gravações representando Bashir |

Para verificar a sua autenticidade, consultamos primeiro uma equipe de especialistas sudaneses da BBC Monitoring. Ibrahim Haithar nos disse que provavelmente não seriam recentes:

"A voz parece a de Bashir, mas ele tem estado muito doente nos últimos anos e duvido que consiga falar tão claramente."

Isso não significa que não seja ele.

Também verificamos outras possíveis explicações, mas este não é um clipe antigo ressurgindo e dificilmente será obra de um impressionista.

A evidência mais conclusiva veio de um usuário do X, antigo Twitter.

Eles reconheceram a primeira das gravações de Bashir publicada em agosto de 2023. Aparentemente, mostra o líder criticando o comandante do exército sudanês, general Abdel Fattah Burhan.

A gravação de Bashir coincidiu com uma transmissão ao vivo do Facebook transmitida dois dias antes por um popular comentarista político sudanês, conhecido como Al Insirafi. Acredita-se que ele more nos Estados Unidos, mas nunca mostrou seu rosto diante das câmeras.

O par não soa muito parecido, mas os scripts são os mesmos e, quando você reproduz os dois clipes juntos, eles são reproduzidos perfeitamente sincronizados.

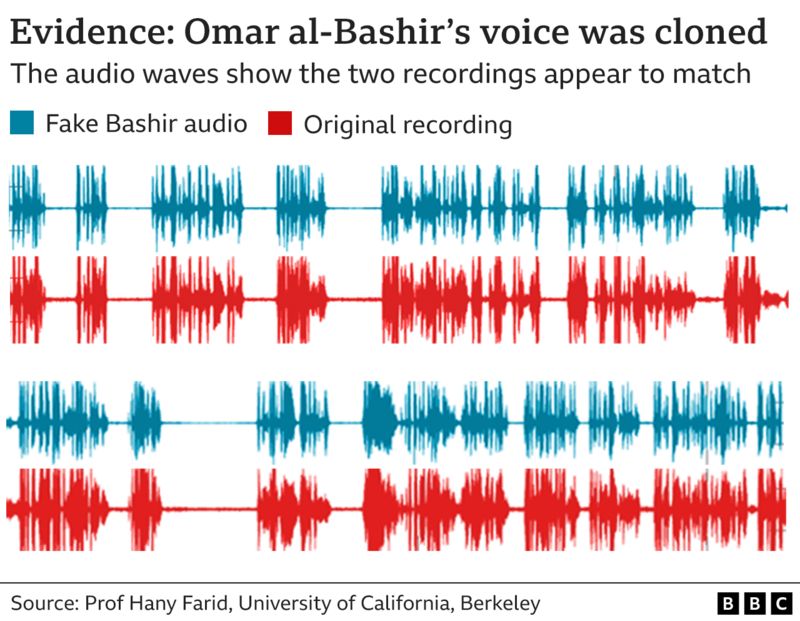

A comparação das ondas de áudio mostra padrões semelhantes na fala e no silêncio, observa Farid.

As evidências sugerem que o software de conversão de voz tem sido usado para imitar a fala de Bashir. O software é uma ferramenta poderosa que permite fazer upload de um trecho de áudio, que pode ser alterado para diferentes vozes.

Depois de mais pesquisas, surgiu um padrão. Encontramos pelo menos mais quatro gravações de Bashir que foram tiradas das transmissões ao vivo do mesmo blogueiro. Não há evidências de que ele esteja envolvido.

A conta TikTok é exclusivamente política e requer um conhecimento profundo do que se passa no Sudão, mas quem se beneficia desta campanha está em debate. Uma narrativa consistente é a crítica ao chefe do exército, Gen Burhan.

A motivação pode ser fazer com que o público acredite que Bashir surgiu para desempenhar um papel na guerra. Ou o canal pode estar tentando legitimar um determinado ponto de vista político usando a voz do antigo líder. Qual pode ser esse ângulo não está claro.

A The Voice of Sudan nega ter enganado o público e diz que não está afiliado a nenhum grupo. Entramos em contato com a conta e recebemos uma resposta em texto dizendo: “Quero comunicar minha voz e explicar a realidade que meu país atravessa no meu estilo”.

Um esforço desta escala para personificar Bashir pode ser visto como “significativo para a região” e tem o potencial de enganar o público, diz Henry Ajder, cuja série na BBC Radio 4 examinou a evolução dos meios de comunicação sintéticos.

Os especialistas em IA há muito se preocupam com o facto de vídeos e áudios falsos conduzirem a uma onda de desinformação, com potencial para desencadear agitação e perturbar eleições.

“O que é alarmante é que essas gravações também podem criar um ambiente onde muitos não acreditam mesmo em gravações reais”, diz Mohamed Suliman, pesquisador do Civic AI Lab da Northeastern University.

Como você pode detectar desinformação baseada em áudio?

Como vimos neste exemplo, as pessoas deveriam questionar se a gravação parece plausível antes de compartilhá-la.

Verificar se foi divulgado por uma fonte confiável é vital, mas verificar o áudio é difícil, principalmente quando o conteúdo circula em aplicativos de mensagens. É ainda mais desafiador durante um período de agitação social, como o que se vive atualmente no Sudão.

A tecnologia para criar algoritmos treinados para detectar áudio sintético ainda está nos estágios iniciais de desenvolvimento, enquanto a tecnologia para imitar vozes já está bastante avançada.

Depois de ser contatado pela BBC, o TikTok retirou a conta do ar e disse que ela violava suas diretrizes sobre publicação de “conteúdo falso que pode causar danos significativos”, e suas regras sobre o uso de mídia sintética.

Artigos recomendados: DPF e Sudão

Nenhum comentário:

Postar um comentário